Art et intelligence artificielle, le grand détournement

En introduction du cycleque le Labo Arts & Techs de Stereolux consacre cet automne à l’intelligence artificielle (IA), Nicolas Barrial retrace les relations entre l'intelligence artificielle - et notamment des réseaux neuronaux - et les sphères de l'art et de la culture.

Lorsqu’on aborde l’intelligence artificielle (IA) et ses domaines d’intervention, on est confronté à un questionnement, notamment lorsqu’il s’agit de domaines identitaires chez l’humain. L’IA elle-même interroge sur la définition de l'intelligence. Idem pour la conscience lorsque les techno-optimistes prêchent son hypothétique éveil chez la machine. L’art n’y échappe pas. Si l’on peut s’amuser du cousinage étymologique du mot “artificiel”, l’art constitue bien un trait distinctif de l’humain et la culture ne l’est pas moins. Aussi a-t-on parfois du mal à envisager que l’intelligence artificielle viennent y jouer les trouble-fêtes.

L’apprentissage profond

Et pourtant, en 2015, d’étranges images fleurissent sur les réseaux sociaux, volontiers psychédéliques, avec un fort tropisme canin. Ce sont les “oeuvres” de Deep Dream, un algorithme signé Google. “Deep”, “profond”, fait référence aux couches de neurones d’un réseau neuronal. Cette architecture, calquée sur le cerveau humain, est la signature du machine learning, l’apprentissage automatique. Ce domaine de l’IA vise à se passer, à terme, de programmes instructeurs en s’appuyant sur une meilleure connaissance des données par la machine. D’où le terme d’apprentissage. Avec malice, Google clame à l’époque que Deep Dream a donné naissance à un courant artistique : l’inceptionnisme. Référence au film Inception (2010). La réalité est plus triviale mais pas moins intéressante.

Le détournement

Deep Dream était destiné à un concours de reconnaissance d’images d’animaux. Or, la banque d’images en question, ImageNet, comportait beaucoup de photos de chiens. La raison, c’est la difficulté d’identifier les caractéristiques d’un chien, pensez à la différence entre un Husky et un Yorkshire. Les ingénieurs Google imaginent alors une expérience et donnent l’instruction suivante à l’algorithme: “Ce que tu vois, je veux le voir encore plus”. Deep Dream fait alors une crise de paréidolie, il voit des chiens partout. On avait clairement affaire à un détournement et les artistes n’y sont pas restés indifférents. Par la suite, Google a libéré le code de Deep Dream et d’autres outils de l’IA ont suivi.

L’abstraction et les modèles génératifs

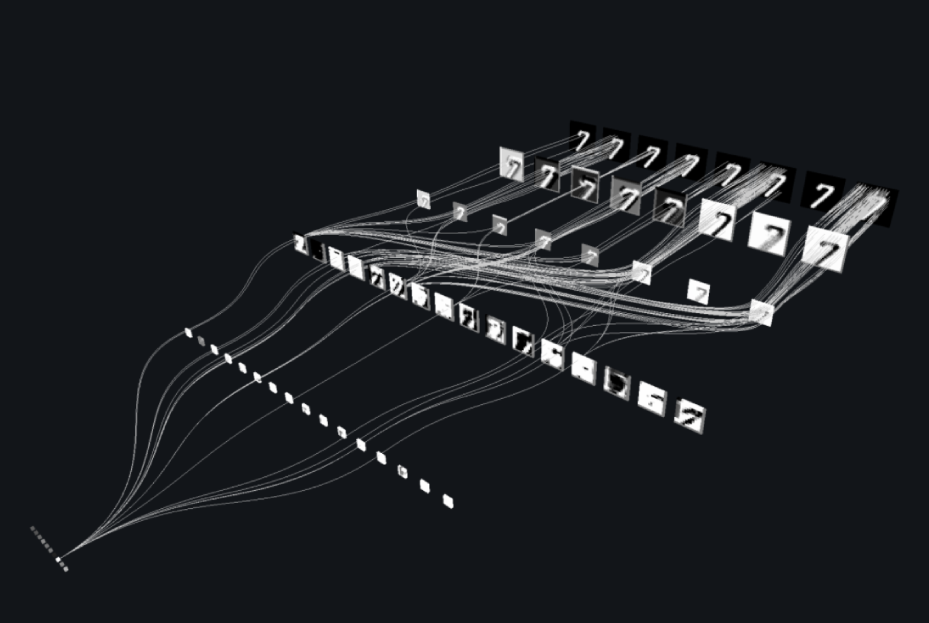

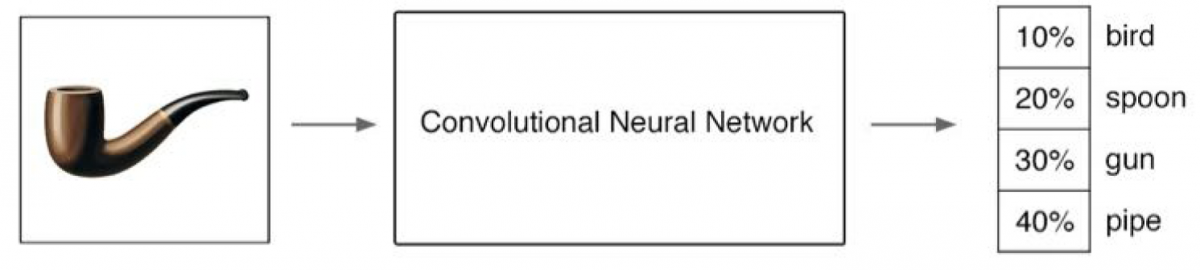

Les réseaux neuronaux décomposent les images (et plus généralement les données), en détails, presque insignifiants, jusqu’à l’abstraction. Cela permet de reconnaître un objet, même d’après un croquis ou un symbole.

Visualisation topologique d’un réseau neuronal - Terence Broad

On imagine alors aisément qu’ils s'insèrent dans des projets culturels. Mais ce n’est pas tout. Jusqu’à récemment, la part belle était faite aux modèles discriminants, autrement dit, l’IA arbitrait entre des données existantes.

Mais lorsqu’on utilise l’IA pour faire des projections, financières par exemple, on fait appel à des modèles génératifs. L’IA se base toujours sur les données existantes mais pour en créer de nouvelles. Créer. Le mot est lâché. Or, récemment, ce modèle a été combiné avec les progrès de la vision par ordinateur (computer vision) et l’IA s’est mise à produire des images troublantes de vérité.

En haut une vidéo, en bas une vidéo générée par un réseau neuronal prédictif. © Coxlab

Les réseaux adversaires

En 2014, Yann Goodfellow, jeune ingénieur de chez Google Brain eut alors l’idée d’associer les deux modèles de réseaux; l’un génère une image, tandis que l’autre, discriminant, choisit si l’image fait partie des données originales. Si l’image est rejetée, le modèle génératif améliore sa proposition. Un cercle vertueux en somme. En 2016, les GAN (Generative Adversarial Networks) ont fait l’objet d’une publication scientifique d’Apple pour améliorer les images de synthèse. Mais les réseaux neuronaux ont aussi leurs détracteurs, jugés pas assez formalistes tant il est difficile de tracer leurs raisonnements. D’autres y voient l’occasion de falsifier l’information ou d’outrepasser les conventions éthiques, comme les métamorphoses ethniques de Faceapp ou le controversé “Gaydar”, développé par l’université de Stanford, qui détecterait l’homosexualité sur les visages. Ce qui fait dire à Alexandre de Brébisson, co-fondateur de Lyrebird, un programme d’IA qui imite les voix, qu’une telle technologie implique de nouvelles responsabilités. Raison de plus pour que la culture s’en mêle.

Par Nicolas Barrial